728x90

1. Why ML strategy & 2. Orthogonalization

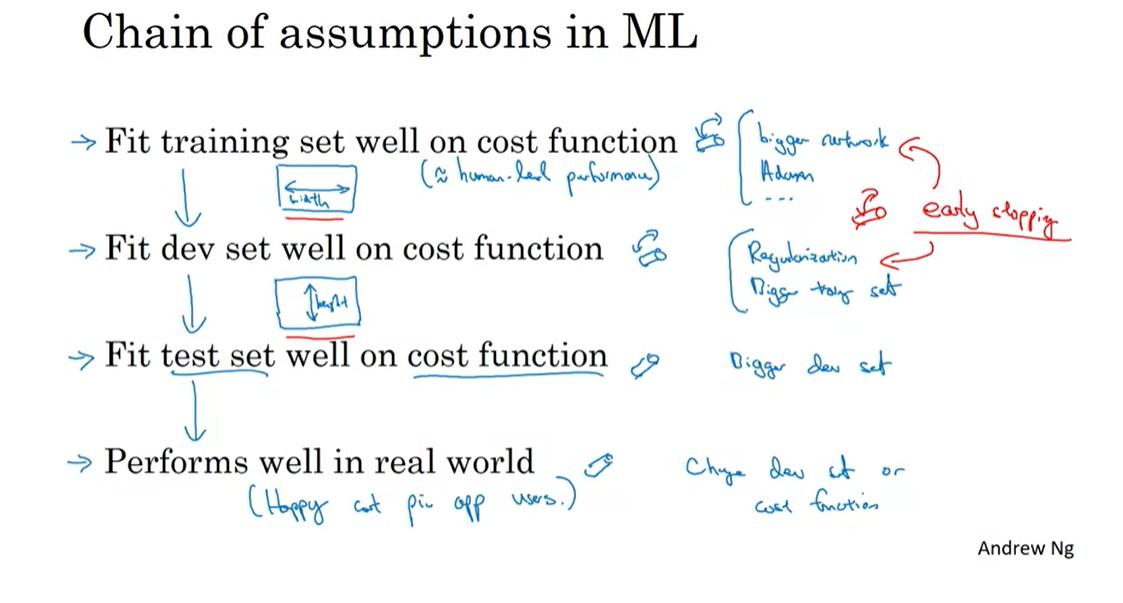

좋은 모델을 튜닝하기 위해서는 여러가지 전략이 필요하다. 그 절차를 쉽게 하기 위해 Orthogonalization(직교화)이라는 것을 활용한다.

직교화란, 1가지 효과를 위한 1가지 기능이라고 이해할 수 있다. 즉, A라는 효과를 위해 a라는 기능을 사용한다는 의미이다. a라는 기능은 오직 A라는 효과를 내는데에만 사용되는 것.

머신러닝의 개괄적인 목표는 위와 같으며 각각의 효과를 위한 기능들은 다음과 같다.

1) cost function이 training set 에 잘 fit 되는 것.

<= 더 큰 network, ADAM opimization

2) cost function이 dev set 에 잘 fit 되는 것.

<= Regularization

<= 더 많은 training set(모델이 training set에 과적합 되었을 수 있으므로 training set을 늘려 과적합 방지)

3) cost function이 test set 에 잘 fit 되는 것.

<= 더 많은 dev set(모델이 dev set에 과적합 되었을 수 있으므로 dev set을 늘려 과적합 방지)

4) 실제로 잘 사용되는 것.

<= dec set의 비율을 바꾸거나 cost function을 재정의

참고로 early stopping 은 1단계와 2단계에 동시다발적으로 영향을 끼쳐 직교화에 어긋나 모델 튜닝에 복잡함을 가져다 준다.

728x90

'DeepLearning Specialization(Andrew Ng) > Structuring Machine Learning Projects' 카테고리의 다른 글

| [Week 2] 3. Learning from multiple tasks (0) | 2020.10.30 |

|---|---|

| [Week 2] 2. Mismatched training and dev/test set (0) | 2020.10.30 |

| [코세라] [Week 2] 1. Error Analysis (0) | 2020.10.30 |

| [Week 1] 3. Comparing to human-level performance (0) | 2020.10.27 |

| [Week 1] 2. Setting up your goal (0) | 2020.10.27 |